Che le macchine mentano per errore o per necessità è una questione più antropologica che tecnologica. Gli esseri umani, purtroppo o per fortuna, mentono spesso con intenzione.

I Large Language Models (LLMs) sembrano mentire per natura.

Si parla di "allucinazioni", termine clinico forse troppo romantico per un fenomeno che emerge freddamente dalla pura matematica degli algoritmi.

La spiegazione più semplice attribuisce queste visioni artificiali a rumore casuale, incidenti di percorso nella generazione stocastica.

È rassicurante immaginarle come errori isolati, come piccoli scivoloni digitali. La verità è un'altra.

Le allucinazioni degli LLM sono strutturali, sistematiche e peggiorano quanto più lunga è la sequenza generata. Non è semplice rumore: è deriva. E come tutte le derive, si amplifica nel tempo. Il modello proposto da LeCunn, che assegna un errore costante a ciascun token (ε), ha un fascino matematico, ma ignora un fatto cruciale: gli LLM sono autoregressivi. Ogni errore influenza il successivo, creando una spirale di inesattezze.

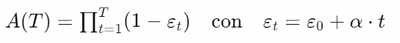

Una modellazione più realistica introduce una dipendenza posizionale:

Qui, ogni termine riflette la probabilità che un singolo token sia corretto. Sebbene ciascuno possa apparire altamente affidabile, la precisione globale degrada rapidamente, manifestando come anche piccole imperfezioni possano crescere esponenzialmente.

Inoltre, per input "fuori distribuzione", dove il modello non riesce a trovare pattern familiari o attrattori stabili, l'accuratezza del primo token stesso può essere bassa, accelerando drasticamente il decadimento dell'accuratezza complessiva. Studi specifici e benchmark ufficiali come TruthfulQA di OpenAI confermano queste dinamiche, mostrando che il problema non è casuale, ma strutturale e sistematico.

Solving hallucinations is a modern day space race.

Chiunque risolva davvero questo problema non avrà semplicemente risolto un bug, ma avrà innescato una rivoluzione. Significherebbe raggiungere un livello di accuratezza (99.999%) che oggi appare lontano come la conquista dello spazio negli anni sessanta. È un problema così profondo e strutturale da definire una nuova era tecnologica, con implicazioni economiche da centinaia di trilioni di dollari.

Non è un caso che nessuno sia ancora arrivato vicino a una soluzione definitiva, nonostante i molti annunci altisonanti.

La verità degli LLM, dunque, resta una meta sfuggente, una frontiera tecnologica che, nonostante enormi investimenti e aspettative, ci ricorda costantemente la complessità e l'imprevedibilità delle macchine intelligenti che stiamo creando. Forse, in fondo, il vero valore sta nel riconoscere con umiltà i limiti della nostra stessa creazione.